-

Rubio, necessario includere missili balistici in negoziati con Iran

Rubio, necessario includere missili balistici in negoziati con Iran

-

La casa di Marilyn Monroe, i proprietari fanno causa a Los Angeles

-

Stefano Bollani a Umbria jazz con All stars-tutta vita live

Stefano Bollani a Umbria jazz con All stars-tutta vita live

-

Love Me Love Me, il nuovo young adult e romance-triangle

-

Budapest condanna a 8 anni per violenza Maja T.

Budapest condanna a 8 anni per violenza Maja T.

-

Calcio: Tonolini sulla giornata degli arbitri, "bene giallo a McKennie"

-

L'assemblea di Mps approva le modifiche allo statuto

L'assemblea di Mps approva le modifiche allo statuto

-

Su Tmz le foto di Epstein morto in cella

-

Trump ritira 700 agenti federali dell'immigrazione da Minneapolis

Trump ritira 700 agenti federali dell'immigrazione da Minneapolis

-

Croce Rossa, 'salgono a 162 i morti dell'attacco in Nigeria'

-

Weekend al cinema, Shakespeare scalda il motore in vista dell'Oscar

Weekend al cinema, Shakespeare scalda il motore in vista dell'Oscar

-

Bonucci 'il bullismo neo della società che si manifesta in tanti modi'

-

Una nuova banca dati per il gemello europeo della Terra

Una nuova banca dati per il gemello europeo della Terra

-

Daniele Taddei nuovo Presidente dell'Unione Imprese Tecniche dell'Anica

-

Il tecnico sul mercato: 'Ho la rosa che volevo. Raspadori? Vediamo per la Coppa Italia'

Il tecnico sul mercato: 'Ho la rosa che volevo. Raspadori? Vediamo per la Coppa Italia'

-

Cargo russo al largo della Sardegna, la Nato monitora gli spostamenti

-

Borsa: Milano supera i 47mila punti, nuovo massimo da novembre 2000

Borsa: Milano supera i 47mila punti, nuovo massimo da novembre 2000

-

Cgil, è crisi per l'industria, oltre 131mila lavoratori coinvolti in tavoli Mimit

-

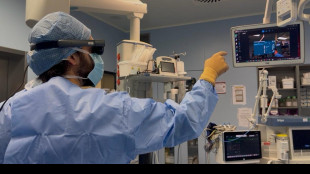

Nella chirurgia maxillo-facciale esordisce il visore di realtà aumentata

Nella chirurgia maxillo-facciale esordisce il visore di realtà aumentata

-

Meryl Streep sarà Joni Mitchell in un nuovo biopic di Cameron Crowe

-

Ismea, Italia primo esportatore mondiale di mele superati Usa e Cina in valore

Ismea, Italia primo esportatore mondiale di mele superati Usa e Cina in valore

-

Napoli: Di Lorenzo infortunato si opera a un piede

-

'Un solo mare', dall'11 febbraio all'Auditorium Parco della Musica

'Un solo mare', dall'11 febbraio all'Auditorium Parco della Musica

-

Michele Zarrillo dal 28 marzo in tour per i 30 anni di L'elefante e la farfalla

-

È nei geni l'arma delle piante contro la mancanza di ossigeno

È nei geni l'arma delle piante contro la mancanza di ossigeno

-

Ritorna 'Giffoni in a Day': cinema, formazione e temi sociali

-

C.Italia: Palladino "sarà una sfida affascinante contro una Juve in crescita"

C.Italia: Palladino "sarà una sfida affascinante contro una Juve in crescita"

-

All'Aquila il concorso internazionale 'Antonellini' per direttori d'orchestra

-

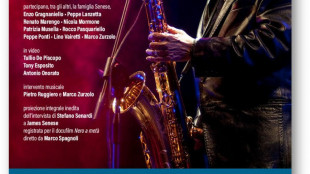

'I respiri di James', omaggio a Senese al Trianon Viviani

'I respiri di James', omaggio a Senese al Trianon Viviani

-

Milano Cortina -2: Franzoni 2/o nella prima prova della libera a Bormio

-

Sanremo, J-Ax porta Cochi, Paolo Rossi, Ale e Franz e Paolo Jannacci per serata cover

Sanremo, J-Ax porta Cochi, Paolo Rossi, Ale e Franz e Paolo Jannacci per serata cover

-

Cinema e musica, Seeyousound torna al grido di 'Make some noise'

-

Tajani, 'sventati cyberattacchi di matrice russa ad ambasciate e hotel Cortina'

Tajani, 'sventati cyberattacchi di matrice russa ad ambasciate e hotel Cortina'

-

Papaleo regista e coprotagonista nel 'viaggio di trasformazione' di Il bene comune

-

Milano Cortina -2: Snoop Dogg tedoforo a Gallarate sotto una finta nevicata

Milano Cortina -2: Snoop Dogg tedoforo a Gallarate sotto una finta nevicata

-

Serie A: sei giocatori squalificati per un turno

-

Charlotte Rampling, 80 anni per un'antidiva, musa del cinema europeo

Charlotte Rampling, 80 anni per un'antidiva, musa del cinema europeo

-

Borsa: l'Europa sale in vista di Wall Street, Milano +1,1%

-

Sull'Himalaya riemergono tracce di due antiche eruzioni marine

Sull'Himalaya riemergono tracce di due antiche eruzioni marine

-

Bill Gates, pentito per Epstein ma falsa l'email sulla malattia

-

Mosca, 'la Nato pianifica un aperto schieramento in Ucraina'

Mosca, 'la Nato pianifica un aperto schieramento in Ucraina'

-

Malagò battuto dal cileno Ilic, non entra in board del Cio

-

David di Donatello, in testa Primavera di Michieletto nelle prime shortlist

David di Donatello, in testa Primavera di Michieletto nelle prime shortlist

-

Ad Umbria Jazz protagonisti anche Gilberto Gil e Gilsons

-

Al Jazeera, il bilancio dei morti a Gaza sale a 21

Al Jazeera, il bilancio dei morti a Gaza sale a 21

-

Calcio: Kanté al Fenerbahçe, obiettivo Mondiali per il francese

-

Sindacati, in Marelli premio medio di 2.500 euro

Sindacati, in Marelli premio medio di 2.500 euro

-

Live Nation acquisisce il gruppo Forumnet

-

Coreve, 'i nuovi standard Ue sul riciclo del vetro discriminano le bottiglie italiane'

Coreve, 'i nuovi standard Ue sul riciclo del vetro discriminano le bottiglie italiane'

-

E' la settimana Stem, dedicata alla ricerca nell'Artico

Il paradosso dei chatbot, più crescono più sbagliano

Dà risposte errate piuttosto che ammettere l'ignoranza

Più crescono e fanno esperienza, maggiore è il rischio che rispondano in modo errato piuttosto che ammettere di non saper rispondere: è uno dei grandi problemi dei grandi modelli linguistici che alimentano i chatbot, come ChatGpt e Llama. A dirlo è lo studio pubblicato sulla rivista Nature da José Hernández-Orallo, dell'Istituto di ricerca per l'Intelligenza Artificiale di Valencia in Spagna, che sottolinea inoltre come questi errori sfuggano facilmente agli umani. Una delle importanti caratteristiche dei grandi modelli linguistici, o Llm, è la capacità di evolvere nel tempo integrando al loro interno nuove informazioni derivanti dalle interazioni con gli utenti o con gli sviluppatori, così da diventare teoricamente sempre più affidabili. Ma analizzando questo percorso in tre degli Llm più polari, in particolare ChatGpt di OpenAi, Llama di Meta e il modello aperto Bloom, i ricercatori spagnoli hanno osservato un cambiamento del loro comportamento. Secondo gli autori della ricerca i tre modelli inizialmente erano più propensi di oggi nell'ammettere di non poter rispondere a domande su questioni su cui non si sentivano certi di dare risposte accurate. Una prudenza che è andata gradualmente svanendo: "i modelli 'ingranditi' e modellati tendono a dare una risposta apparentemente sensata, ma sbagliata, molto più spesso rispetto al passato", affermano i ricercatori nell'articolo. I chatbot "stanno diventando più bravi a fingere di essere informati", ha commentato Hernández-Orallo. Un problema che si aggiunge inoltre all'incapacità da parte degli umani di riuscire a notare questi errori, spesso perché ci si fida automaticamente della macchina. Un problema che potrebbe essere parzialmente risolto impostando negli Llm una sorta di soglia di affidabilità più alta, al di sotto della quale l'IA non rilascia una risposta. Scelta possibile per i chatbot ideati per lavorare in settori specifici, ad esempio in campo medico, ma più difficile immaginare, sottolineano i ricercatori, possa essere introdotta da quelle aziende che sviluppano chatbot 'generalisti' che puntano proprio sulla capacità di risposta in settori molto ampi.

Ferreira--PC