-

Un avatar tridimensionale per comprendere l'osteosarcoma pediatrico

Un avatar tridimensionale per comprendere l'osteosarcoma pediatrico

-

Confindustria-Srm, Sud recupera, verso convergenza con resto d'Italia

-

Fincantieri, accordo con WSense per sviluppo tecnologico wireless underwater

Fincantieri, accordo con WSense per sviluppo tecnologico wireless underwater

-

Michele Mariotti sul podio a Vienna per Luisa Miller

-

Guariti 7 bimbi con malattie autoimmuni gravi grazie alle Car-T

Guariti 7 bimbi con malattie autoimmuni gravi grazie alle Car-T

-

La vedova di Muammar Gheddafi partita dal Cairo per Tripoli

-

Allo scalo di Berlino stop ai decolli in mattinata a causa del ghiaccio

Allo scalo di Berlino stop ai decolli in mattinata a causa del ghiaccio

-

Bitcoin ancora in crisi, scivola a 70.000 dollari

-

Scoperto il circuito cerebrale al cuore del Parkinson, possibili terapie mirate

Scoperto il circuito cerebrale al cuore del Parkinson, possibili terapie mirate

-

Un massiccio blackout lascia senza luce la parte orientale di Cuba

-

Dedicato al vero amore, esce il nuovo singolo di Gianni Fiorellino

Dedicato al vero amore, esce il nuovo singolo di Gianni Fiorellino

-

Consumi in calo nel 2025, ma sale il valore

-

La Corte Ue legittima il divieto italiano sulla coltivazione di mais Ogm

La Corte Ue legittima il divieto italiano sulla coltivazione di mais Ogm

-

Borsa: Milano positiva, scattano Bper e Popolare Sondrio

-

Nba: Jalen Brunson trascina i Knicks alla vittoria sui Nuggets

Nba: Jalen Brunson trascina i Knicks alla vittoria sui Nuggets

-

Per piccole imprese troppe barriere, ottengono solo 5% degli appalti

-

Bnl, utile lordo 2025 sale del 19,4% a 819 milioni

Bnl, utile lordo 2025 sale del 19,4% a 819 milioni

-

Il dollaro si rafforza ancora, l'euro scende sotto 1,18

-

Il petrolio è in calo, Brent a 68 dollari al barile

Il petrolio è in calo, Brent a 68 dollari al barile

-

Il prezzo del gas apre in rialzo a 34,04 euro al megawattora

-

Metalli riducono le perdite, argento in calo del 7,8%

Metalli riducono le perdite, argento in calo del 7,8%

-

Borsa: l'Asia chiude in calo, si riaccendono i timori per l'Ia

-

Bnp, utile 2025 sale a 12,2 miliardi, in trimestre +28%

Bnp, utile 2025 sale a 12,2 miliardi, in trimestre +28%

-

L'arcivescovo di Los Angeles prega per gli immigrati: 'Il Paese sappia accogliere'

-

Venezuela, il legale dell'ex ministro Alex Saab smentisce il suo arresto

Venezuela, il legale dell'ex ministro Alex Saab smentisce il suo arresto

-

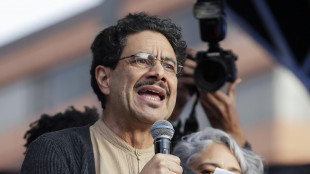

Colombia, il Consiglio elettorale esclude Iván Cepeda dalle primarie della sinistra

-

Argentina-Usa, intesa sui minerali critici

Argentina-Usa, intesa sui minerali critici

-

Coppa Italia: Chivu, abbiamo sofferto un po' nel finale ma siamo contenti

-

Milano Cortina: slittino, Fischnaller subito veloce allo Sliding Centre

Milano Cortina: slittino, Fischnaller subito veloce allo Sliding Centre

-

Ovs prevede di chiudere l'anno con ricavi in crescita a 1,74 miliardi

-

'Amministrazione Trump contro Nike per discriminazione dipendenti bianchi'

'Amministrazione Trump contro Nike per discriminazione dipendenti bianchi'

-

'Consigliere diplomatico di Macron ha incontrato Ushakov ieri a Mosca'

-

Mosca, 'le parti del New Start non più vincolate dagli obblighi dell'accordo'

Mosca, 'le parti del New Start non più vincolate dagli obblighi dell'accordo'

-

Trump, 'Khamenei dovrebbe essere preoccupato ora'

-

On line i nuovi contributi 2026 per colf, badanti, baby sitter

On line i nuovi contributi 2026 per colf, badanti, baby sitter

-

Usa-Ue-Giappone annunciano partner strategica sui minerali critici

-

Media Israele, 'saltano i colloqui Usa-Iran, posizioni troppo distanti'

Media Israele, 'saltano i colloqui Usa-Iran, posizioni troppo distanti'

-

Ciclismo: Europei pista, due argenti per l'Italia dalle donne

-

Erdogan regala ad Al Sisi un'auto elettrica turca

Erdogan regala ad Al Sisi un'auto elettrica turca

-

Next Land e Stellantis, al via la Winter Camp

-

Se si dorme male in un letto nuovo, il segreto è in un gruppo di neuroni

Se si dorme male in un letto nuovo, il segreto è in un gruppo di neuroni

-

Da Acquirente Unico bond per 600 milioni. Pichetto, operazione di rilievo

-

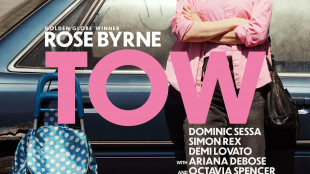

Rose Byrne, dalla corsa all'Oscar a una donna che vive in auto

Rose Byrne, dalla corsa all'Oscar a una donna che vive in auto

-

Fondazione Barilla, parte Grand Tour del Libro del Risparmio, recuperabili 500 euro l'anno

-

Serie A: Doveri dirigerà Verona-Pisa, Guida per Juve-Lazio

Serie A: Doveri dirigerà Verona-Pisa, Guida per Juve-Lazio

-

Borsa: Milano chiude poco sotto i 47mila punti, sprint di Mediobanca

-

Mit, campagna di richiamo Takata, 'verifica se il tuo veicolo è coinvolto'

Mit, campagna di richiamo Takata, 'verifica se il tuo veicolo è coinvolto'

-

Industria e ricerca insieme per non perdere le opportunità quantistiche

-

Borsa: Europa contrastata in chiusura, Parigi +1,01%, Francoforte -0,72%

Borsa: Europa contrastata in chiusura, Parigi +1,01%, Francoforte -0,72%

-

Una medaglia per il quarto posto, i bozzetti degli studenti dell'Ipzs

L'IA non capisce davvero cos'è un fiore per gli esseri umani

Si basa solo su parole e immagini, non può annusarlo e toccarlo

I sistemi basati sull'Intelligenza Artificiale come ChatGpt non riescono a capire davvero cos'è un fiore e cosa rappresenta per un essere umano: il problema è che tutto ciò che sanno arriva da parole e in alcuni casi immagini, e queste informazioni non possono compensare l'assenza di un esperienza diretta, della possibilità di annusarlo, toccarlo o passeggiare in un campo pieno di fiori. Lo afferma lo studio pubblicato sulla rivista Nature Human Behaviour e guidato dall'Università Statale dell'Ohio, che ha messo a confronto come IA e umani vedono il mondo che ci circonda. I ricercatori guidati da Qihui Xu e Yingying Peng sono partiti da oltre 4.400 parole, da 'fiore' a 'umoristico', e hanno messo alla prova due famiglie di sistemi all'avanguardia: ChatGpt 3.5 e 4 di OpenAI e i modelli linguistici Palm e Gemini di Google. Umani e IA sono stati testati su due parametri: il primo chiede di valutare quanto un concetto sia facile da visualizzare mentalmente e quanto sia emotivamente stimolante, mentre il secondo valuta quanto stretto sia il legame tra un concetto e le informazioni che è possibile ottenere su di esso tramite i sensi o tramite azioni. L'obiettivo era vedere quanto IA e umani siano allineati nelle loro valutazioni. I modelli linguistici hanno ottenuto ottimi risultati nel rappresentare parole che non avevano alcun collegamento con i sensi, ma quando si è trattato di parole strettamente legate a quello che vediamo, gustiamo o annusiamo hanno invece fallito. "Ottengono ciò che sanno assimilando enormi quantità di testo - afferma Xu - e tuttavia non riescono a catturare alcuni concetti allo stesso modo degli umani. L'esperienza umana - aggiunge - è molto più ricca di quanto le parole possano contenere da sole". Gli autori dello studio sottolineano, però, che i modelli linguistici sono in continuo miglioramento ed è quindi probabile che faranno progressi anche in questo campo, soprattutto se verranno potenziati con dati provenienti da sensori esterni che gli permetteranno di avere un esperienza diretta degli oggetti.

O.Gaspar--PC