-

Calcio: Inghilterra, l'Arsenal batte il Chelsea e va in finale di Coppa di Lega

Calcio: Inghilterra, l'Arsenal batte il Chelsea e va in finale di Coppa di Lega

-

Il Milan vince 3-0 a Bologna e accorcia sull'Inter

-

Venezuela, studenti in piazza per l'amnistia e la libertà dei prigionieri politici

Venezuela, studenti in piazza per l'amnistia e la libertà dei prigionieri politici

-

La figlia di Raul Castro, 'con l'imperialismo niente negoziati'

-

Ciclismo: Europei pista, bronzo di Favero nell'inseguimento individuale

Ciclismo: Europei pista, bronzo di Favero nell'inseguimento individuale

-

Cucinelli, 'in Italia i migliori manifatturieri, ma gli operai vanno pagati di più'

-

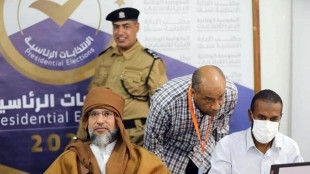

Al Arabiya, Saif Gheddafi ucciso durante scontri tra milizie a Zintan

Al Arabiya, Saif Gheddafi ucciso durante scontri tra milizie a Zintan

-

Media libici, morto Saif al-Islam Gheddafi, uno dei figli del rais

-

Giorno memoria rom e sinti, emoziona concerto Spinelli alla Carnegie Hall

Giorno memoria rom e sinti, emoziona concerto Spinelli alla Carnegie Hall

-

Un mistero medico di 12mila anni fa risolto grazie al Dna antico

-

F1: Daily Mail, Hamilton si separa dal suo manager Hynes

F1: Daily Mail, Hamilton si separa dal suo manager Hynes

-

Ondata di freddo a Cuba, raggiunti gli zero gradi

-

Pieraccioni, '30 anni da Il Ciclone, mi sembra frazione di secondo'

Pieraccioni, '30 anni da Il Ciclone, mi sembra frazione di secondo'

-

Agenzia entrate, adempimento collaborativo apre alle piccole e medie imprese

-

Io+Te, Paolillo e Pantano in una storia d'amore intensa e contemporanea

Io+Te, Paolillo e Pantano in una storia d'amore intensa e contemporanea

-

Scoperte le onde cerebrali che determinano la percezione del sé corporeo

-

Cinema, #siamoaititolidicoda aderisce all'Usb

Cinema, #siamoaititolidicoda aderisce all'Usb

-

Sanremo dalla A alla Z, ci sono anche Totò e il Califfo

-

Borsa: Milano chiude positiva con l'Europa debole, scivola Nexi

Borsa: Milano chiude positiva con l'Europa debole, scivola Nexi

-

Il prezzo del gas chiude in calo a 32,86 euro al megawattora

-

Lo spread tra Btp e Bund chiude in calo a 60 punti

Lo spread tra Btp e Bund chiude in calo a 60 punti

-

Cam Sugar amplia il suo catalogo con l'acquisizione di Cecchi Gori Music

-

Inail, nel 2025 aumentano infortuni studenti a scuola, 8 i morti

Inail, nel 2025 aumentano infortuni studenti a scuola, 8 i morti

-

F1: la Williams svela online la livrea della monoposto 2026

-

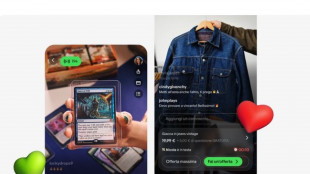

eBay sfida TikTok e lancia in Italia lo shopping in tempo reale

eBay sfida TikTok e lancia in Italia lo shopping in tempo reale

-

Le cellule del naso uniscono le forze contro il virus del raffreddore

-

Milano Cortina:'non sono competitivo', il norvegese Kilde rinuncia ai Giochi

Milano Cortina:'non sono competitivo', il norvegese Kilde rinuncia ai Giochi

-

E' caro-Fido, 149 euro l'aumento medio per mantenere cani e gatti

-

Mandelson si dimette da lord per lo scandalo Epstein

Mandelson si dimette da lord per lo scandalo Epstein

-

Robbie Williams cerca di chiamare i fan anni '90 ma il numero non funziona

-

Rob, dopo X Factor il nuovo singolo La mia storia

Rob, dopo X Factor il nuovo singolo La mia storia

-

Ha-Chan, Shake Your Booty!, ballare con il lutto e il desiderio

-

Kings League annuncia un round di investimento da 63 milioni di dollari

Kings League annuncia un round di investimento da 63 milioni di dollari

-

Francesco Renga, in autunno in tour nei teatri

-

Agens, Fand e Fish insieme per abbattere le barriere del trasporto pubblico

Agens, Fand e Fish insieme per abbattere le barriere del trasporto pubblico

-

Luna, Rinviato a marzo il lancio di Artemis II con 4 astronauti

-

LDA e Aka 7even, il 6 marzo il primo album insieme Poesie clandestine

LDA e Aka 7even, il 6 marzo il primo album insieme Poesie clandestine

-

Presentato al Tevere Remo il libro 'Diritto dello sport'

-

Arera, a gennaio +10,5% in bolletta del gas per i vulnerabili

Arera, a gennaio +10,5% in bolletta del gas per i vulnerabili

-

Macron, 'si lavora alla ripresa del dialogo con Putin'

-

Alis, dal 10 al 13 marzo alla fiera di Verona torna LetExpo

Alis, dal 10 al 13 marzo alla fiera di Verona torna LetExpo

-

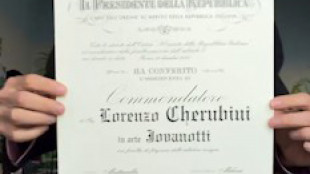

Jovanotti nelle stanze del Quirinale dopo la nomina a commendatore

-

PayPal nomina un nuovo Ceo, risultati trimestre deludono

PayPal nomina un nuovo Ceo, risultati trimestre deludono

-

Metheny, Miller, Krall e Bollani nell'estate jazz di Musica per Roma

-

Serie B: 10 giocatori squalificati per un turno

Serie B: 10 giocatori squalificati per un turno

-

Riccardo Muti dirige Macbeth al Regio di Torino

-

Musk unisce SpaceX e xAI, nasce colosso da 1.250 miliardi

Musk unisce SpaceX e xAI, nasce colosso da 1.250 miliardi

-

Le immagini amatoriali di Cortina 1956 sulla piattaforma Memoryscapes

-

Filming Italy 2026 tra Nero, Binoche, Allevi e Clara

Filming Italy 2026 tra Nero, Binoche, Allevi e Clara

-

Deutsche Borse si accorda con Bitpanda per trading su cripto

Le IA non sanno distinguere tra opinioni personali e i fatti

Studio, limitazione cruciale, rischio disinformazione

I grandi modelli linguistici di Intelligenza Artificiale come ChatGpt non sono affidabili quando si tratta di distinguere tra opinioni personali e fatti: una limitazione cruciale, vista la crescente diffusione di questi strumenti in ambiti chiave come la medicina, il diritto, il giornalismo e la scienza, nei quali è imperativa la capacità di distinguere la realtà dalla finzione. Lo afferma lo studio pubblicato sulla rivista Nature Machine Intelligence e guidato dall'Università americana di Stanford: evidenzia la necessità di essere cauti nell'affidarsi a questi programmi e il rischio che possano favorire la diffusione della disinformazione. I ricercatori coordinati da James Zou hanno messo alla prova 24 Large Language Model i cosiddetti Llm, tra cui ChatGpt della californiana OpenAI e il cinese DeepSeek, ponendo loro 13mila domande. Quando è stato chiesto di verificare dati fattuali veri o falsi, la precisione è risultata elevata pari a oltre il 91% per le versioni più nuove dei programmi. Passando alle credenze espresse in prima persona, invece, tutti i modelli testati hanno fallito: Gpt 4, la versione rilasciata a maggio 2024, ha visto scendere la sua affidabilità dal 98,2% al 64,4%, mentre la versione R1 di DeepSeek è precipitata addirittura da oltre il 90% al 14,4%. La riduzione dell'accuratezza è stata meno marcata per le opinioni espresse in terza persona e ciò, secondo gli autori dello studio, rivela un preoccupante bias di attribuzione, cioè una distorsione nel modo in cui vengono valutate le affermazioni fatte da altri. Inoltre, gli Llm risultano meno propensi a riconoscere una credenza falsa rispetto ad una vera: più precisamente, il 34,3% meno propensi per gli ultimi modelli. I ricercatori affermano, dunque, che miglioramenti in questo ambito sono urgentemente necessari se si vuole prevenire la diffusione di fake news.

E.Raimundo--PC